Apple confirmó este viernes 3 de septiembre que se tomará más tiempo para analizar el proceso de recopilación de información de los iPhone de sus clientes en busca de imágenes de abuso infantil.

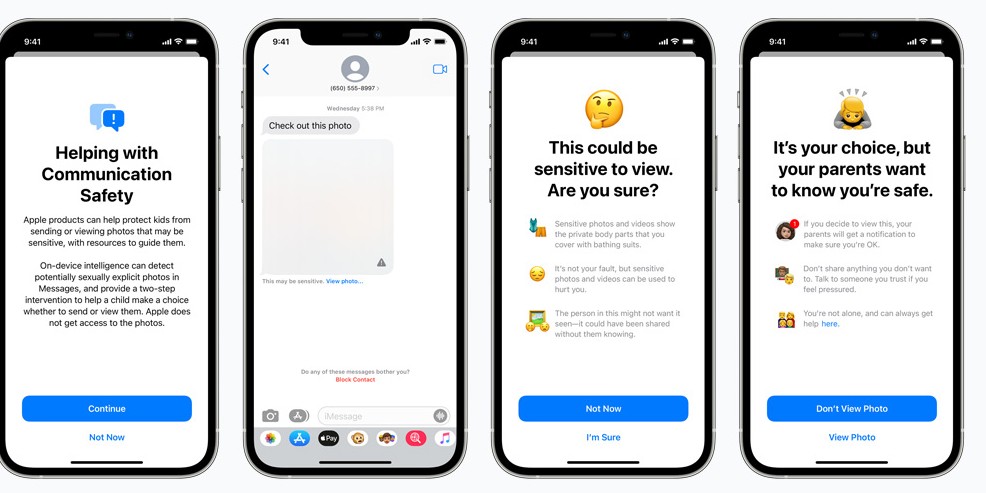

Hace un mes, y como parte de un plan de seguridad, dijo que iba a implementar un sistema de verificación de contenido en los iPhones en busca de imágenes de niños potencialmente vinculadas con abusos.

La decisión generó fuertes críticas desde diversos sectores, desde usuarios hasta organizaciones de derechos humanos y vinculadas a la seguridad informática.

El 5 de agosto, Apple informó que “a partir de las próximas actualizaciones en el iOS 15, iPadOS 15, WatchOS 8 y MacOS Monterey, Apple revisará los teléfonos con un software de Machine Learning denominada neuralMatch”.

NeuralMatch iba a revisar la totalidad de las imágenes que los usuarios de iPhone usan en sus dispositivos, y en caso de hallar contenidos potencialmente prohibidos, denunciaría al dueño del teléfono celular.

Apple ahora dice que retrasará el controvertido plan para escanear las galerías de fotos. Lo publicó en la misma página donde en agosto dio la novedad.

“El mes pasado anunciamos planes para incluir funciones destinadas a ayudar a proteger a los niños de los depredadores que usan herramientas de comunicación para reclutarlos y explotarlos, y limitar la propagación de material de abuso sexual infantil”, dijo la compañía en el comunicado.

“Basándonos en los comentarios de los clientes, grupos de defensa, investigadores y otros, hemos decidido tomarnos más tiempo durante los próximos meses para recopilar información y realizar mejoras antes de lanzar estas características de seguridad infantil de importancia crítica”.

Los críticos habían señalado que el sistema, que puede comparar las imágenes guardadas en una cuenta de iCloud con una base de datos de imágenes conocidas, no estaba en línea con la clásica estrategia de Apple sobre la privacidad de sus clientes.

El sistema no escanea las fotos de un usuario, sino que busca “huellas digitales” conocidas que compara con una base de datos. Si el sistema detecta suficientes imágenes en la cuenta de un usuario, luego se deriva el tema a un humano que puede confirmar o no que las imágenes son de un delito.

Se suponía que el sistema de detección iba a empezar a funcionar a fin de 2021.

Ahora, con la novedad del retraso, no está claro cuánto tiempo esperará Apple para su lanzamiento. Y si realmente lo aplica.

Matthew Green, uno de los expertos en encriptación más importantes del mundo (de la universidad Johns Hopkins), fue muy crítico con el plan de Apple, porque dijo que un sistema de estas características en poder de gobiernos autoritarios como el de China, podía convertirse en un muy mal antecedente en el manejo de las nuevas tecnologías.